بهینهسازی موتور جستجو

برای تأییدپذیری کامل این مقاله به منابع بیشتری نیاز است. (سپتامبر ۲۰۱۵) |

| بخشی از یک سری در |

| بازاریابی اینترنتی |

|---|

| بازاریابی موتورهای جستجو |

| Display advertising |

| فروش رابطهای |

| تبلیغات در تلفن همراه |

بهینهسازی موتور جستجو یا سئو (به انگلیسی: SEO، مخفف Search Engine Optimization)، به مجموعه اقداماتی گفته میشود که با به کار بردن آنها، صفحات یک وبسایت یا یک صفحه وب در نتایج جستجوی یک موتور جستجو بالاتر از رقبا دیده میشود.[۱] معمولاً وبسایتهایی که بالاترین مکان و بیشترین تکرار در صفحه نتایج جستجو را دارند، بازدیدکننده بیشتری از طریق موتورهای جستجو نظیر گوگل به دست میآوردند و این بازدیدکنندگان میتوانند به مشتری تبدیل شوند.

مهمترین سؤالی که کاربران از خود میپرسند آن است که تعریف دقیق سئو چیست. سئو مجموعه فعالیتهایی است که در طراحی سایت، تعیین استراتژی محتوایی و تولید محتوا انجام میدهیم تا جایگاه بهتری در نتایج جستجوی گوگل کسب کرده و بازدیدکننده بیشتری برای طراحی وب سایت جذب کنیم.

سئو انواع گوناگون جستجو را دربرمیگیرد؛ از جمله جستجوی تصویر، جستجو در ویدیو، جستجوی دانشگاهی، جستجو در اخبار و جستجو در نقشه. «سئو» یک سایت شامل فاکتورهای زیادی میشود، که توسط موتورهای جستجو بررسی و بازبینی میشوند. این فاکتورها را میتوان به دو بخش کلی تقسیم نمود؛ سئوی درون صفحهای (on-page seo) و سئوی خارجی(off-page seo) که در ادامه به هر کدام خواهیم پرداخت.

از دید بازاریابی اینترنتی، «سئو» به چگونگی کار کردن موتورهای جستجو و اینکه کاربران چه چیزی جستجو میکنند و همینطور کلمات کلیدی تایپشده و اینکه کدام یک از موتورهای جستجو توسط مخاطبان مورد توجه قرار میگیرد را مورد بررسی قرار میدهد.

سئو یا بهینهسازی وبسایت، شامل توسعه و ویرایش مطالب موجود در خود سایت و اچتیامال و برنامهنویسی و همچنین ارتباط بین کلمات کلیدی و حذف موانع مربوط به فعالیتهای نمایهسازی در موتور جستجو و ترویج یک سایت، برای افزایش تعداد لینکدهنده یا لینکهای ورودی و دیگر تاکتیکهای جستجوگرها است. برای بهبود سئو سایت بهتر است با مهمترین الگوریتمهای تأثیرگذار در سئو سایت آشنا شده و کاربرد هر الگوریتم در بهبود بهینهسازی سایت را مورد بررسی قرار دهید.

در نتیجه در خلاصهترین تعریف «سئو» را میتوان به معنای بهینهسازی سایت برای موتورهای جستجو دانست.

اهمیت سئوی سایت چیست؟

امروزه اینترنت به بخش جدایی ناپذیر زندگی ما تبدیل شدهاست و افراد برای پاسخ به کوچکترین نیازهایشان مثل خرید خمیردندان، از اینترنت کمک میگیرند. در این میان موتورهای جستجو مانند گوگل نقش مهمی در کیفیت نتایج جستوجو و رساندن کاربر به هدف اصلی او دارد. موتور جستجوی گوگل با الگوریتمهایی که دارد همواره سعی میکند بهترین نتیجه را برای کاربر نمایش دهد. برای اینکه یک کسب و کار بتواند در اینترنت باشد میبایست با توجه به این الگوریتمها بتواند کاری انجام دهد که در صفحه اول گوگل(serp) قرار گیرد و بیشترین میزان ورودی را جذب کند. سئو به خصوص برای کسبو کارها بسیار مهم است. از آنجایی که اینترنت در تمام لایههای زندگی ما نفوذ کرده و صنایع مختلف را تحت تأثیر قرار دادهاست، باید کسبوکارها برای کسب درآمد و افزایش فروش خود از ان استفاده کنند.

| دانش مالی |

|---|

|

برای اینکه بتوانیم در جایگاههای بالاتر قرار بگیریم میبایست فرایندی به نام سئو بر روی سایت انجام شود تا متناسب با الگوریتمهای گوگل بتوانیم لینکها را در نتایج بالاتر نمایش دهیم.

تاریخچهٔ سئو

از اواسط دهه ۱۹۹۰ میلادی که نخستین موتورهای جستجو اقدام به فهرست کردن وب نخستین کردند. مدیران وبگاهها، تولیدکنندگان محتوا و کارشناسان سئو، شروع به بهینهسازی وبسایتها برای موتورهای جستجو نمودند.

در ابتدا تمام کارهایی که مدیران وبسایتها باید انجام میدادند، ارسال آدرس صفحه به موتورهای مختلفی که یک «عنکبوت» جهت «خزش» آن صفحه میفرستاد، استخراج لینکهای صفحه به سایر صفحات از درون صفحه و بازگرداندن اطلاعات یافتشده در صفحه، جهت ایندکس شدن بود.

فرایند به این صورت است که عنکبوت موتور جستجو، یک صفحه را دانلود و آن را در سرور موتور جستجو ذخیره میکند و یک برنامه دیگر موسوم به ایندکس کننده، اطلاعات مختلفی را دربارهٔ صفحه استخراج میکند؛ اطلاعاتی از قبیل واژههای موجود و محل قرارگیری آنها در صفحه و نیز وزن خاص واژههای بهخصوص و تمام لینکهای موجود در صفحه، که سپس جهت خزش در زمانی دیگر، در دستور کار قرار میگیرد.

مدیران سایتها شروع به بازشناسی ارزش رتبه بالای سایت خود و در دید قرار گرفتن آن در نتایج موتورهای جستجو نمودند که این امر، فرصتی را برای هکرهای غیرمخرب و مخرب شاغل در بخش بهینهسازی موتور جستجو مهیا کرد.

نسخههای اولیه الگوریتمهای جستجو به اطلاعات فراهمشده توسط مدیران وبسایتها، نظیر متا تگ واژههای کلیدی، یا فایل ایندکس موتورهای جستجو، مانند ایالآیوب اعتماد و اتکا میکردند. متاتگها یک راهنمایی برای محتوای هر صفحه فراهم میکنند.

با این حال، استفاده از دادههای متا در صفحات ایندکس، کمتر قابل اطمینان بود؛ زیرا انتخاب واژگان در یک متاتگ توسط وبسایتها، بالقوه میتواند یک نمایش غیردقیق از محتوای واقعی وبسایت باشد. دادههای نادرست، ناقص و ناسازگار در متا تگها میتواند موجب رتبهبندیشدن صفحه برای جستجوهای غیرمرتبط گردد. تولیدکنندگان محتوای شبکه، همچنین تعدادی از ویژگیهای منبع اچتیامال، یک صفحه را دستکاری کردند تا رتبه صفحه را در موتورهای جستجو بهبود بدهند.

با تأکید بر عواملی مانند تراکم واژه کلیدی، که بهطور انحصاری تحت کنترل مدیر وبسایت است، موتورهای جستجوی اولیه از سوءاستفاده و دستکاری رتبهبندی رنج میبردند.

ازآنجاییکه موفقیت و محبوبیت یک موتور جستجو از طریق توانایی آن در تولید نتایج مرتبطتر در قبال هر جستجوی صورت گرفته مشخص میشود، کیفیت پایین یا نتایج نامرتبط میتواند سبب سوق دادن کاربران به منابع جستجوی دیگر شود. موتورهای جستجو با توسعه الگوریتمی رتبهبندی پیچیدهتر به این عمل پاسخ دادند؛ که در آن عوامل بیشتری مورد توجه قرار میگیرند و دستکاری را برای مدیران شبکه، سختتر میسازند.

بهمنظور ارائه نتایج بهتر به کاربران خود، موتورهای جستجو باید انطباق یافته و از نتایج صفحاتی اطمینان یابند که نتایج مرتبطتری دارند، نه نتایج مربوط به صفحاتی که نامربوط بوده و توسط مدیران شبکه بدون وجدان کاری و با استفاده از کلمات کلیدی متعدد پرشدهاند.

لری پیج و سرگئی برین، دو دانشجوی فارغالتحصیل دانشگاه استنفورد، یک موتور جستجو موسوم به بکروب را توسعه دادند که جهت ارزیابی برجستگی صفحات وب، به یک الگوریتم ریاضیاتی تکیه داشت. عددی که توسط الگوریتم محاسبه میشد، یعنی «رتبه صفحه»، تابعی است از مقدار و قدرت لینکهای ورودی. رتبه صفحه، میزان یک صفحه معین را که توسط یک کاربر، که بهصورت تصادفی شبکه را جستجو میکند، مورد دسترسی قرارگرفته، تخمین میزند و لینکهای یک صفحه به صفحه دیگر را دنبال میکند.

درواقع، این بدان معناست که برخی لینکها از سایر لینکها قویتر بوده، رتبه صفحه بالاتر احتمال دیده شدن صفحه توسط وبگردهای تصادفی را افزایش میدهد.

انحصار گوگل در بازار موتورهای جستجو

گوگل از چند دهه گذشته بسیار پیشرفت کرده و توانسته جایگزین تمام موتورهای جستجویی مانند بینگ، یاهو و… شود و تبدیل به بزرگترین و پرطرفدارترین موتور جستجوگر دنیا شود. گوگل در حال حاضر در سال ۲۰۲۳ نزدیک به ۹۲ درصد سهم از بازار موتورهای جستجو را در اختیار دارد. امروزه هر کجا که نامی از سئو شنیده میشود ما را به یاد گوگل میاندازد چرا که گوگل پیشرفتهترین الگوریتمها را برای سایتها در نظر گرفتهاست.

پیچ و برین، گوگل را در سال ۱۹۹۸ بنیانگذاری کردند. گوگل درمیان کاربران فزاینده اینترنت، هواداران ثابتقدمی را به خود جذب کرد که طراحی ساده آن را دوست داشتند. عوامل خارج از صفحه (مانند رتبه صفحه و تجزیه تحلیل لینک) نیز همانند عوامل داخل صفحه (فراوانی واژههای کلیدی، متاتگها، عنوانها، لینک و ساختار وبسایت) مورد توجه قرار گرفتند تا گوگل را قادر به این امر سازند که از نوعی دستکاری که در موتورهای جستجویی دیده میشود، که تنها به عوامل داخل صفحه توجه میکنند، اجتناب نماید.[۲]

علیرغم اینکه به بازی گرفتن رتبه صفحه سختتر بود، مدیران شبکه سرانجام ابزارها و طرحهای تولید لینک را جهت تحت تأثیر قرار دادن موتور جستجوی اینکتومی توسعه دادند و این روشها ثابت کردند که به طریقی مشابه میتوان رتبه صفحه را تحت تأثیر قرار داد.

بسیاری از وبسایتها روی تبادل، خریدوفروش لینک در حجم زیاد و وسیع متمرکز هستند. بعضی از این طرحها یا مزارع لینک، موجب ایجاد هزاران وبسایت برای فروش هرزنگاری لینکها میشوند.

گوگل اینستنت، یا جستجوی زمان واقعی، در اواخر سال ۲۰۱۰ در تلاشی بهمنظور بههنگامتر و مرتبط نمودن جستجوها ارائه شد. بهطور تاریخی، مدیران وبسایتها، ماهها یا حتی سالها روی بهینهسازی یک وبسایت و ارتقای رتبهٔ جستجوی آن زمان گذاشتهاند.

با گسترش عمومیت وبسایتها و وبلاگهای رسانههای اجتماعی، موتورهای جستجوی پیشرفته در الگوریتمهای خود تغییراتی ایجاد کردند تا مطالب تازه به سرعت در میان نتایج جستجو رتبهبندی شوند.

در فوریه ۲۰۱۱، از آپدیت پاندا خبر داد که وبسایتهایی را که حاوی محتوای تکثیرشده از وبسایتها و منابع دیگر باشند، جریمه میکند. بهطور تاریخی، وبسایتها محتوا را از یکدیگر کپی کرده و از آن در رتبهبندی موتورهای جستجو بهرهمند شدهاند. با این حال، گوگل یک سیستم جدید پیادهسازی کرد که سایتهایی را که حاوی محتوای منحصربهفرد نیستند، جریمه میکند.

در آوریل ۲۰۱۲، گوگل از آپدیت گوگل پنگوئن رونمایی کرد که هدف آن، جریمه کردن وبسایتهایی بود که از روشهای دستکاری جهت بهبود رتبه خود در موتورهای جستجو استفاده میکردند.

در سپتامبر ۲۰۱۳، کمپانی گوگل از آپدیت الگوریتم مرغ مگسخوار رونمایی کرد؛ یک الگوریتم که جهت بهبود پردازش زبان طبیعی گوگل و درک معنایی صفحات وب طراحی شد.

در سپتامبر سال ۲۰۱۶، گوگل اعلام کرد که گوگل پنگوئن به الگوریتم اصلی رتبهبندی گوگل ملحق شدهاست و دیگر آپدیتهای آن اعلام نمیشود. از سال ۲۰۱۶ به بعد، الگوریتم پنگوئن گوگل دیگر به صورت لحظهای نتایج جستجو را بررسی خواهد کرد.

گوگل الگوریتم محتوای مفید (helpful content) را در اواسط سال ۲۰۲۲ منتشر کرد. این بهروزرسانی جدید و بزرگ الگوریتم «محتوای وبسایتها را هدف قرار میدهد که به نظر میرسد در درجه اول برای رتبهبندی خوب در موتورهای جستجو ایجاد شدهاست تا کمک یا اطلاعرسانی به مردم».[۳]

ارتباط با موتورهای جستجو

تا سال ۱۹۹۷، طراحان موتورهای جستجو دریافتند که مدیران وبسایتها تلاش میکنند که در موتورهای جستجوی آنها رتبه بهتری داشته باشند. آنان همچنین متوجه شدند که برخی از مدیران وب، حتی رتبههای خود در نتایج جستجو را از طریق لبریز نمودن صفحات خود با واژگان کلیدی بسیار زیاد یا نامرتبط، دستکاری میکردند.

موتورهای جستجوی اولیه، نظیر آلتا ویستا یا اینفوسیک، الگوریتمهای خود را جهت جلوگیری مدیران وب در دستکاری رتبهها، مجدداً سازگار کردند.

در سال ۲۰۰۵، یک اجلاس سالانه موسوم به بازیابی اطلاعات خصمانه در وب (AIRWeb) صورت گرفت تا شاغلان و محققان مرتبط با موتورهای جستجو و بهینهسازی آن را به هم مرتبط سازد.

نکته قابلتأمل در مورد موتورهای جستجو این است که نیاز نیست در تمام موتورهای جستجو سئو انجام دهید؛ جالب است بدانید ۹۷٪ جستجوهای کل دنیا از طریق موتور جستجوی گوگل انجام میشود و کارشناسان و مدیران وب تمایل بیشتری به سئو سازی روی گوگل داشته و سئو خود را متمرکز به گوگل میکنند.

سئو درون صفحهای و سئوی خارجی

سئوی درون صفحهای (on page) و سئوی خارجی (off page) دو مفهوم اصلی و کلی در دنیای سئو میباشند:

on page SEO یا سئو درون صفحه ای

آن پیج سئو یا سئو درون صفحهای به تمامی فعالیتهایی گفته میشود که شما بر روی سایت خود انجام میدهید تا سایت شما در موتورهای جستجو در جایگاه بالاتری قرار بگیرد. این موارد خودشان به دو قسمت تقسیم میشوند: ۱. سئوی فنی یا همان سئوی تکنیکال (Technical SEO)

- سرعت لود سایت

- رسپانسیو بودن قالب

- بهینهسازی تصاویر و ویدئو

۲. سئو محتوا

- بهینهسازی محتوا

- تگهای بدنه

- چگالی کلمات کلیدی

- بهینهسازی تصاویر (alt تصاویر)

- لینکدهی داخلی مناسب

- تگ توضیحات مناسب (Meta Description)

- بهینهسازی عناوین محصولات، دستهبندی محصولات و برگههای خدمات

off page SEO یا سئو خارجی

به مجموعه فعالیتهایی گفته میشود که در خارج از سایت خود انجام میدهید تا رتبه بهتری در موتورهای جستجو کسب کنید. این امور شامل موارد زیر است:

- لینک سازی در شبکههای اجتماعی مختلف

- تبلیغات و رپورتاژ آگهی در سایتهایی با دامین آتوریتی و تاپیکال آتوریتی مناسب

- لینک سازی در پروفایل سایتهای خارجی معتبر

- تولید محتوا در وبلاگها و سایتهای معتبر و لینک سازی خارجی

- استفاده از رباتهایی مانند gsa, money robot و… (سئو کلاه سیاه محسوب میشود)

- کامنت گذاری در سایتهای مختلف و قرار دادن لینک در سایت

- لینک سازی از طریق ایمیل مارکتینگ

روشها

رابط کاربری مناسب

رابط کاربری (UI) و تجربه کاربری (UX) از عوامل بسیار مهم در طراحی و توسعه وبسایتها محسوب میشوند. اما آیا میدانید که رابط کاربری مناسب نقش مهمی در بهبود سئو و رتبهبندی وبسایت در موتورهای جستجو ایفا میکند؟ در این متن، تأثیر مثبت رابط کاربری مناسب بر بهبود سئو و رتبهبندی وبسایت را بررسی خواهیم کرد

سرعت سایت

در دنیای امروزه اینترنت، سرعت و بهرهوری از زمان بسیار حائز اهمیت است. همچنین، تأثیر سرعت سایت بر سئو یکی از موارد بحثبرانگیز و کلان در دنیای تجارت آنلاین است. سرعت لود یک وبسایت اثرات عمیقی بر تجربه کاربری دارد و همچنین به شکل مستقیم روی رتبهبندی و موقعیت یک سایت در نتایج جستجوی موتورهای جستجوی اثر میگذارد. در این متن، به بررسی چگونگی تأثیر سرعت سایت بر بهبود سئو و رتبهبندی در موتورهای جستجو پرداخته خواهد شد.

تجربه کاربری بهتر

سرعت لود صفحات وب تأثیر مستقیمی بر تجربه کاربری دارد. کاربران تمایل دارند به سرعت و بدون تأخیر به اطلاعات مورد نیاز دسترسی پیدا کنند. اگر یک وبسایت به خوبی بهینه نشده باشد و صفحات آن با تأخیر بالا لود شوند، کاربران ممکن است احتمالاً از این تجربه ناخوشایند ناشی از زمان برداشت بیش از حد برای بارگذاری صفحه منصرف شوند

کاهش نرخ خروج

سرعت سایت تأثیر مستقیمی بر نرخ خروج (Bounce Rate) دارد. اگر کاربران به دلیل عدم صبر در انتظار بارگذاری صفحه از سایت خارج شوند، نرخ خروج بالا خواهد رفت. این مسئله نشاندهنده عدم جذب کاربران توسط محتوای سایت و تأثیر منفی آن بر سئو است.

تأثیر مستقیم بر سئو

موتورهای جستجوی امروزی مانند گوگل، سرعت سایت را به عنوان یکی از عوامل مهم در رتبهبندی سایتها در نتایج جستجو در نظر میگیرند. سرعت لود صفحات یک سایت به عنوان یکی از عوامل اصلی در ارزیابی کیفیت وبسایت در نظر گرفته میشود.

فهرستشدن

موتورهای جستجوی پیشرو مانند جستجوگر گوگل، بینگ، یاهو! جستجو، بایدو از خزندهها جهت پیداکردن صفحات مرتبط با نتایج جستجوی الگوریتم خود استفاده میکنند. صفحاتی که از صفحات ایندکسشده یک موتور جستجوی دیگر لینک میشوند، نیازی به ارسال ندارد زیرا بهطور خودکار پیدا میشوند.

دو دایرکتوری عمده یاهو دایرکتوری، دیموز نیازمند ارسال دستی و بازنگری انسانی هستند. شرکت گوگل، Google Search Console را پیشنهاد میدهد که یک فید نقشه سایت اکسامال میتواند برای آن ایجاد و بهطور رایگان ارسال شود تا این اطمینان حاصل شود که تمامی صفحات، خصوصاً آنهایی که با دنبال کردن خودکار لینکها قابلشناسایی نیستند، قابلدستیابی هستند. در گذشته یاهو، یک سرویس ارسال پرداختی داشت که خزش را به ازای مقداری هزینه در هر کلیک تضمین میکرد؛ که در سال ۲۰۰۹، این سرویس متوقف شد

خزندههای موتور جستجو میتوانند هنگام خزش یک وبسایت، به تعداد عوامل مختلفی توجه کنند. هر صفحهای توسط موتور جستجو ایندکس نمیشود. فاصله صفحات از دایرکتوری اساسی ممکن است یک عامل در خزش یا عدم خزش در صفحات باشد.

جلوگیری از خزش (noindex)

بهمنظور جلوگیری از محتوای نامطلوب در ایندکسهای جستجو، مدیران شبکه میتوانند به عنکبوتها (به انگلیسی: Spider) دستور بدهند که فایلها یا دایرکتوریهای خاصی را درون فایل استاندارد robots.txt در دایرکتوری اصلی دامنه، مورد بررسی و خزش (به انگلیسی: Crawl) قرار ندهند. بهعلاوه، یک صفحه میتواند صراحتاً از پایگاه دادهها مورد جستجو خارج شود؛ که این عمل از طریق استفاده از متاتگهای مخصوص به رباتها صورت میگیرد. هنگامی که یک موتور جستجو از یک سایت بازدید میکند فایل robots.txt واقع در دایرکتوری اصلی، نخستین جایی است که مورد خزش قرار میگیرد. سپس فایل robots.txt تجزیه شده و به ربات دستور داده میشود که کدام صفحات نباید مورد بررسی و خزش قرار گیرد. از آنجایی که خزنده موتور جستجو ممکن است که یک نسخه از این فایل را نگه دارد، گاهی ممکن است که صفحاتی مورد خزش قرار گیرند که مدیر شبکه تمایلی به آنها ندارد.[۴] بهطور معمول، صفحاتی که از خزش خارج میشوند عبارتاند از صفحات ورودی خاص، مانند صفحات مربوط به کارتهای خرید و صفحات مربوط به محتوای شخصی کاربر، نظیر نتایج جستجوی حاصل از جستجوهای داخلی. در مارس ۲۰۰۷، گوگل به مدیران شبکه هشدار داد که باید از ایندکسشدن نتایج جستجوی داخلی جلوگیری کنند؛ زیرا این صفحات، هرزنامه جستجو هستند. در ادامه بحث گفتنی است: نبود سایت مپ نیز مانع از آن میشود که ربات درک درستی از صفحات شما داشته باشد. همواره یک سایت مپ خوب تأثیر بسیار مهمی در خزش درست و خواندن کامل صفحات شما را دارد.[۵]

افزایش برتری

از روشهای مؤثر در برتری در لینکهای گوگل، میتوان به سوشال ها (صفحات اجتماعی)، ساخت بکلینکهای طبیعی در صفحات اجتماعی و ارسال دیدگاه در وبسایتهای دیگران اشاره کرد. در این بین باید توجه کافی را داشته باشید تا از سایتهای اسپم شده لینک نگیرید که باعث رشد منفی سایت شما خواهد شد. تکنیکهای برتر دیگری که در این مقوله استفاده میشود، توجه به استانداردهای w3c است که سئوی وبگاه را بهبود بخشیده و کمک شایانی به آن وبگاه میکند. استفاده از گوگلسرچکنسول و تنظیم آن، میتواند کمک ویژهای به آگاهی شما نسبت به شرایط آن سایت کند.[۶]

روشهای کلاه سفید در مقابل تکنیکهای کلاه سیاه

روشهای سئو را میتوان به دو دسته طبقهبندی کرد:

- روش سئو کلاه سفید: این روش مطابق با استاندارهای موتورهای جستجو است.

- روش سئو کلاه سیاه: این روش مطابق با استانداردهای موتورهای جستجو نیست.

موتورهای جستجو در ستیز با روش کلاهسیاه بودهاند. دریافت نتیجه در روش سئو کلاه سفید زمان طولانیتری میبرد اما ماندگارتر است؛ در حالی که دریافت نتیجه در در روش سئو کلاه سیاه اگر هم زودبازده باشد، موقتی است و هنگامی که موتورهای جستجو پی به این رفتارهای غیراصولی ببرند، وبگاه را جریمه خواهند کرد.[۷]

البته ناگفته نماند روش دیگری میز موسوم به کلاه خاکستری نیز وجود دارد که ترکیبی از روشهای کلاه سفید و سیاه است و توسط برخی از متخصص های سئو حرفهای استفاده میشود.

واژگان در پستها و عنوان

موتورهای جستجو الگوسازیهای هوشمندی برای جداسازی زبانهای کشورهای مختلف از یکدیگر دارند. برای مثال فارسی و عربی هردو با خط عربی نوشته میشوند و حتی از نظر واژگان نیز تا اندازه قابل توجهی مشابه هم هستند. برای مثال در یک جستجوی خبری از سیستم درون ایران آن خبری بالاتر میآید که متن آن دارای واژگان دارای حرفها و واژگان انحصاری فارسی به اندازه بالاتری باشد. در سال ۲۰۱۹ این تکنیک برای وبگاههای بالای یک میلیون در ردهبندی الکسا نیز کاربردی بودهاست و انحصاری بودن واژگان پست در زبان هدف وبگاه (مثلاً انگلیسی یا فارسی)، از سالهای دور به عنوان یک الگوی معتبر کاربردی در نظر گرفته شدهاست. اینکه واژگان انحصاری در زبان کشور در پستها و عنوان مهم هستند تأیید شده اما اهمیت کاربردشان در برچسبها هرگز اشاره نشدهاست.[۸][۹]

سئو تصاویر

در قدیم، سئو تنها شامل تکرار کلمات کلیدی میشد. اما امروزه با هوشمند شدن گوگل، دیگر این روشها جوابگو نیست. باید از انواع محتوای جذاب برای رضایت کاربرها استفاده کرد تا مطلب را بهتر متوجه بشوند. همانطور که متن و محتوا باید سئو شده باشد، تصاویر، ویدیوها، فایل PDF و بقیه محتواها نیز باید سئو و برای گوگل بهینه بشوند. برای سئو کردن تصاویر باید چند کار انجام دهید:

- نوشتن تگ alt مرتبط با تصویر و شامل کلمه کلیدی

- نام گذاری صحیح تصاویر

- انتخاب ابعاد مناسب برای تصویر

- در نظر گرفتن ابعاد موبایل برای تصاویر

- انتخاب فرمت مناسب عکس برای قراردادن در وبسایت

- پایین آوردن حجم تصاویر

- استفاده از تصاویر با کیفیت

- استفاده از تصاویر یونیک و غیر کپی

- استفاده از عکس نوشتههای مرتبط با مطلب و کمک کننده به کاربر

- استفاده از فرمت WEBP برای تصاویر

با انجام دادن این فعالیتها، عکس خود را سئو کردهاید و میتواند به شما برای کسب رتبه بالاتر در موتورهای جستجو و افزایش کاربر کمک شایانی کند. برای تغییر فرمت و بهینه سازی تصاویر می توانید از فوتوشاپ استفاده کنید.

بهعنوان یک استراتژی بازاریابی

سئو یک روش و استراتژی بازاریابی مناسب برای همه وبسایتها نیست و بر اساس هدف گردانندگان یک وبسایت، استراتژیهای بازاریابی اینترنتی دیگر مانند تبلیغات از طریق پرداخت کلیکی میتواند مؤثرتر باشد. اگر به دنبال نتیجه گیری در کوتاه مدت هستید بهتر است از سئو استفاده نکنید.

همچنین، یک کمپین تبلیغات اینترنتی موفق میتواند به ساختن صفحات وب دارای کیفیت بالا بستگی داشته باشد که بهکارگیری نرمافزارهای تحلیل را ترغیب مینماید تا صاحبان سایتها قادر به ارزیابی نتایج، و بهبود نرخ تبدیل سایت شوند. مهمترین استراتژی بازاریابی محتوا تمرکز بر سئو است.

بازارهای جهانی

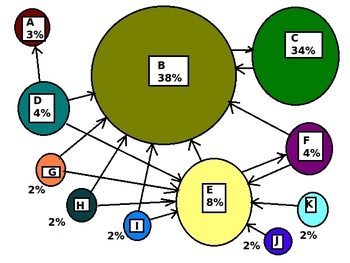

تکنیکهای بهینهسازی شدیداً متناسب با موتورهای جستجو غالب در بازار هدف تنظیم میشوند. سهام بازار موتورهای جستجو از بازاری به بازاری دیگر و مانند وجود یک رقابت، تغییر میکنند. در سال ۲۰۰۳، دنی سالیوان اظهار کرد که گوگل حدود ۷۵ درصد کل جستجوها را انجام دادهاست.[۱۰] در بازارهای خارج از آمریکا، سهم گوگل اغلب بیشتر است و از سال ۲۰۰۷، گوگل در جایگاه موتور جستجوی غالب در سراسر جهان باقی ماندهاست.

از سال ۲۰۰۶، گوگل ۸۵ تا ۹۰ درصد سهم بازار آلمان را در اختیار دارد. درحالیکه صدها شرکت سئو در آن زمان در آمریکا وجود داشت، فقط حدود ۵ مورد از آن در آلمان کار میکرد. از ژوئن ۲۰۰۸، بر اساس اعلام هیتوایس، سهم گوگل از بازار بریتانیا نزدیک به ۹۰ درصد بودهاست. آن عدد از طریق چند کشور حاصل میشود.[۱۱]

از سال ۲۰۰۹، تنها چند بازار بزرگ وجود دارد که گوگل در آنها، موتور جستجوی پیشرو نیست. در اغلب موارد، هنگامی که گوگل در یک بازار خاص پیشرو نیست، پشت سر یک رقیب محلی قرار دارد. قابلتوجهترین نمونههای این موارد، کشورهای چین، ژاپن، کره جنوبی، روسیه و جمهوری چک هستند که به ترتیب، بایدو، یاهو، ژاپن، ناور، یاندکس و شزنم پیش روی بازارها هستند.

بهینهسازی جستجوی موفق برای بازارهای بینالمللی، ممکن است نیازمند ترجمه حرفهای صفحات وب، ثبت یک دامنه با یک دامنه سطح بالا در بازار هدف و میزبانی است که آدرس IP محلی را فراهم نماید.

در غیر این صورت، بدون توجه به زمان، عناصر اساسی بهینهسازی جستجو، اساساً مشابه هستند.

از آیتمهایی که به سئو سایت مربوط میشود، میتوان به بهینهسازی متا و کلمات کلیدی سایت، طراحی و واکنش گرا بودن قالب سایت، لینکهای معتبر، محتوای بهروز و منحصربهفرد و سرعت بارگذاری سایت اشاره کرد که با بهبود این موارد میتوان رتبه بهتری در موتورهای جستجو کسب کرد.

پیشینه حقوقی

در ۱۷ اکتبر ۲۰۰۲، سرچکینگ در دادگاه منطقهای آمریکا در منطقه غربی اوکلاهاما، دادخواستی علیه موتور جستجوی گوگل داد. او ادعا کرد که تاکتیکها و روشهای گوگل در جلوگیری از هرز آگهیها، موجب ایجاد یک تداخل زیانآور با روابط قراردادی شدهاست. در ۲۷ می ۲۰۰۳، دادگاه شکایت علیه گوگل را رد کرد؛ زیرا سرچکینگ نتوانست ادعایش را که میتوانست منجر به دریافت خسارت شود، اثبات کند.

در مارس ۲۰۰۶، کیندراستارت به دلیل رتبهبندیهای موتور جستجوی گوگل، در دادگاه طرح دعوی کرد. پیش از این اقامه دعوی، وبسایت کیندراستارت از ایندکس گوگل خارج شد و ترافیک سایت تا ۷۰ درصد کاهش یافت. در ۱۶ مارس ۲۰۰۷، دادگاه منطقهای آمریکا در منطقه شمالی کالیفرنیا (بخش سن خوزه)، شکایت کیندراستارت را رد کرده و این شرکت را مکلف به پرداخت بخشی از هزینههای حقوقی گوگل کرد.[۱۲][۱۳]

جستارهای وابسته

منابع

- ↑ «What is SEO? | SEO Meaning & Definition». Webopedia (به انگلیسی). ۲۰۱۰-۰۱-۰۴. دریافتشده در ۲۰۲۱-۰۲-۱۷.

- ↑ «The Anatomy of a Search Engine». infolab.stanford.edu. دریافتشده در ۲۰۲۱-۰۲-۱۷.

- ↑ "Helpful content update". searchengineland (به انگلیسی).

- ↑ «Newspapers Amok! New York Times Spamming Google? LA Times Hijacking Cars.com?». Search Engine Land. ۲۰۰۷-۰۵-۰۸. دریافتشده در ۲۰۲۱-۰۲-۱۷.

- ↑ «Google Downgrades Nofollow Directive. Now What?». Practical Ecommerce (به انگلیسی). ۲۰۲۰-۰۲-۲۴. دریافتشده در ۲۰۲۱-۰۲-۱۷.

- ↑ «Partnering to help solve duplicate content issues». blogs.bing.com. دریافتشده در ۲۰۲۱-۰۲-۱۷.

- ↑ «Black Hat/White Hat Search Engine Optimization». www.searchengineguide.com. بایگانیشده از اصلی در ۱۴ سپتامبر ۲۰۱۹. دریافتشده در ۲۰۱۹-۱۱-۱۶.

- ↑ Seo 2019; Actionable, Hands-On Seo, Including a Full Site Audit, Andy Williams, 232-239.

- ↑ Mastering Front-End Web Development (Second), 140.

- ↑ «USATODAY.com - The search engine that could». usatoday30.usatoday.com. دریافتشده در ۲۰۲۱-۰۲-۱۷.

- ↑ "Google UK closes in on 90% market share". the Guardian (به انگلیسی). 2008-06-10. Retrieved 2021-02-17.

- ↑ Engines، Eric Goldman · in Search (۲۰۰۷-۰۳-۲۰). «KinderStart v. Google Dismissed-With Sanctions Against KinderStart's Counsel». Technology & Marketing Law Blog (به انگلیسی). دریافتشده در ۲۰۲۱-۰۲-۱۷.

- ↑ Engines، Eric Goldman · in Search (۲۰۰۶-۰۳-۲۱). «Google Sued Over Rankings-KinderStart.com v. Google». Technology & Marketing Law Blog (به انگلیسی). دریافتشده در ۲۰۲۱-۰۲-۱۷.

پیوند به بیرون

- Google Webmaster Guidelines

- Yahoo! Webmaster Guidelines

- Bing Webmaster Guidelines

- "The Dirty Little Secrets of Search," article in نیویورک تایمز (۱۲ فوریه ۲۰۱۱)

- Google I/O 2010 – سئو site advice from the experts در یوتیوب – Technical tutorial on search engine optimization, given at گوگل آی/او ۲۰۱۰.