یادگیری عمیق

| یادگیری ماشین و دادهکاوی |

|---|

|

| بخشی از مقالهها درباره |

| هوش مصنوعی |

|---|

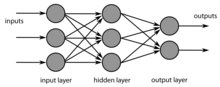

یادگیری عمیق، یادگیری ژرف یا ژرفآموزی (به انگلیسی: Deep learning) (به بیانی دیگر: یادگیری ژرف ماشین، یادگیری ساختار ژرف یا یادگیری سلسله مراتبی) یک زیر شاخه از یادگیری ماشین و بر مبنای مجموعهای از الگوریتمها است که در تلاشند تا مفاهیم انتزاعی سطح بالا در دادگان را مدل نمایند که این فرایند را با استفاده از یک گراف عمیق که دارای چندین لایه پردازشی متشکل از چندین لایه تبدیلات خطی و غیرخطی هستند، مدل میکنند. به بیان دیگر پایهٔ آن بر یادگیری نمایش دانش و ویژگیها در لایههای مدل است.[۱]

به قولی دیگر «یادگیری عمیق» یک نوع «یادگیری ماشین» به همراه شبکههای عصبی چندلایه است که با دقتی فزاینده الگوهای موجود در دادهها کشف کرده و به همینخاطر میتواند علائق کاربر را بشناسد، اشیا را شناسایی کرده و زبانها را بفهمد.[۲]

یک نمونه آموزشی (برای نمونه: تصویر یک گربه) میتواند به صورتهای گوناگون بسان یک بردار ریاضی پر شده از مقدار به ازای هر پیکسل و در دید کلیتر به شکل یک مجموعه از زیرشکلهای کوچکتر (نظیر اعضای صورت گربه) مدلسازی شود. برخی از این روشهای مدلسازی سبب ساده شدن فرایند یادگیری ماشین (برای نمونه: تشخیص تصویر گربه) میشوند. در یادگیری عمیق امید به جایگزینی استخراج این ویژگیهای تصویر به دست بشر (مانند اعضای گربه) با روشهای کاملخودکار بینظارت و نیمهنظارتی وجود دارد.[۳]

انگیزهٔ نخستین در به وجود آمدن این ساختار یادگیری از راه بررسی ساختار عصبی در مغز انسان الهام گرفته شدهاست که در آن یاختههای عصبی با فرستادن پیام به یکدیگر درک را امکانپذیر میکنند.[۴] بسته به فرضهای گوناگون در مورد نحوهٔ اتصال این یاختههای عصبی، مدلها و ساختارهای مختلفی در این حوزه پیشنهاد و بررسی شدهاند، هرچند که این مدلها به صورت طبیعی در مغز انسان وجود ندارد و مغز انسان پیچیدگیهای بیشتری را دارا است. این مدلها نظیر شبکه عصبی عمیق، شبکه عصبی همگشتی، شبکه باور عمیق و چندین نمونه دیگر؛ پیشرفتهای خوبی را در حوزههای پردازش زبانهای طبیعی، پردازش تصویر ایجاد کردهاند.

در حقیقت عبارت یادگیری عمیق، بررسی روشهای تازه برای شبکه عصبی مصنوعی است.[۵][۶]

تعریف

[ویرایش]یادگیری عمیق، ردهای از الگوریتمهای یادگیری ماشین است[۷]: ۱۹۹–۲۰۰ که از چندین لایه برای استخراج ویژگیهای سطح بالا از ورودی خام استفاده میکنند. به بیانی دیگر، ردهای از تکنیکهای یادگیری ماشین که از چندین لایهٔ پردازش اطلاعات و بهویژه اطلاعات غیرخطی بهره میبرد تا عملیات تبدیل یا استخراج ویژگی نظارتشده یا نظارتنشده را عموماً با هدف تحلیل یا بازشناخت الگو، کلاسبندی، خوشهبندی انجام دهد.[۸]

برای نمونه، در پردازش تصویر، لایههای پستتر میتوانند لبهها را تشخیص دهند، در حالی که لایههای عالیتر ممکن است ویژگیهای پرمعناتر برای انسان، همچون حروف یا چهرهها، را تشخیص دهند.

مفهوم

[ویرایش]

یادگیری عمیق زیرشاخهای از یادگیری ماشین است که از لایههای متعدد تبدیلات خطی به منظور پردازش سیگنالهای حسی مانند صدا و تصویر استفاده میکند. ماشین در این روش هر مفهوم پیچیده را به مفاهیم سادهتری تقسیم میکند، و با ادامهٔ این روند به مفاهیم پایهای میرسد که قادر به تصمیمگیری برای آنها است و بدین ترتیب نیازی به نظارت کامل انسان برای مشخص کردن اطلاعات لازم ماشین در هر لحظه نیست. موضوعی که در یادگیری عمیق اهمیت زیادی دارد، نحوهٔ ارائهٔ اطلاعات است. ارائه دادن اطلاعات به ماشین باید به شیوهای باشد که ماشین در کمترین زمان اطلاعات کلیدی را که میتواند با استناد به آنها تصمیم بگیرد را دریافت کند. هنگام طراحی الگوریتمهای یادگیری عمیق میبایست به عوامل دگرگونی (به انگلیسی: factors of variation) که اطلاعات مشاهده شده را توضیح میدهند توجه کنیم، این عوامل معمولاً عوامل قابلمشاهدهای نیستند بلکه عواملی هستند که بر روی دستهٔ قابلمشاهده تأثیرگذار بوده یا زادهٔ ساختارهای ذهنی انسان برای سادهتر کردن مسائل هستند. برای مثال در هنگام پردازش گفتار عوامل دگرگونی میتوانند لهجهٔ گوینده، سن یا جنسیت او باشند. در هنگام پردازش تصویر یک ماشین، میزان درخشش خورشید یک عامل دگرگونی است. یکی از مشکلات هوش مصنوعی تأثیر زیاد عوامل دگرگونی بر روی اطلاعات دریافتی است. برای مثال بسیاری از پیکسلهای دریافتی از یک ماشین قرمز در شب ممکن است سیاه دیده بشوند. برای حل این مشکلات بعضاً به درک بالای اطلاعات (در حدود انسان) نیازمندیم و در واقع گاهی یافتن نحوهٔ مناسب نمایش اطلاعات به اندازهٔ خود مسئله سخت و زمانبر است.

تاریخچه

[ویرایش]نخستین الگوریتم عملی یادگیرنده برای پرسپترونهای چندلایهٔ نظارتشده، عمیق و پیشخور، در دههٔ ۱۹۶۰ توسط الکسی ایواخننکو - معروف به «پدر یادگیری عمیق»[۱۰] - و والنتن لاپا منتشر شد.[۱۱] در سال ۱۹۷۱، مقالهای یک شبکهٔ عمیق با هشت لایه را توصیف کرد که عملیات یادگیری را با متد گروهی مدیریت داده (GMDH) انجام داده بود.[۱۲] سایر معماریهای یادگیری عمیق و به ویژه آنهایی که برای بینایی رایانه ساخته شده بودند، در ۱۹۸۰ و با Neocognitron معرفیشده توسط کونیهیکو فوکوشیما آغاز گشتند.[۱۳]

لفظ یادگیری عمیق، نخستینبار در ۱۹۸۶ و توسط رینا دِختِر در زمینهٔ یادگیری ماشین به کار رفت؛ وی در مقالهای تحت عنوان یادگیری به هنگام جستجو در مسائل ارضای محدودیت (Learning While Searching in Constraint-Satisfaction-Problems) از این لفظ برای پروسهای استفاده کرد که در آن تمامی راهحلها در یک فضای جستجو که به پاسخ مناسب نمیرسیدند نیز ذخیره میشدند. تحلیل این راهحلهای ذخیرهشده امکان کنترل بهتر در تلاشهای بعدی را ممکن میساخت، و به دنبال آن در همان مراحل نخستین از گیر کردن در بنبستهای احتمالی نیز جلوگیری میکرد.[۱۴][۱۵] با این وجود امروزه لفظ یادگیری عمیق عموماً در حوزهٔ شبکههای عصبی مصنوعی به کار میرود که نخستینبار در سال ۲۰۰۰ و توسط ایگور آیزنبرگ و همکاران در حوزهٔ یادشده استفاده شد؛ بهطور دقیقتر، در کتاب نورونهای دودویی چندمقداری و جهانی: نظریه، یادگیری و کاربردها (Multi-Valued and Universal Binary Neurons: Theory, Learning and Applications) و در زمینهٔ نورونهای حدآستانهٔ بولی.[۱۶][۱۷]

در سال ۱۹۸۹، یان لیکان و همکاران الگوریتم استاندارد پسانتشار را برای یک شبکهٔ عصبی عمیق با هدف تشخیص متنهای دستنویس (بهطور خاص با هدف بازشناسی کدهای پستی دستنویس روی نامههای پستی) به کار بست. درحالی که الگوریتم کار میکرد، عملیات یادگیری آن به سه روز زمان نیاز داشت. مدل مورد استفاده از یک لایهٔ ورودی با ۲۵۶ واحد (پیکسلهای یک تصویر مربعی ۱۶×۱۶)، یک لایهٔ خروجی با ۱۰ واحد (که مشخص میکرد تصویر رقمی که به ورودی دادهشدهاست، کدام یک از ارقام ۰ تا ۹ است) و سه لایهٔ پنهان در میان این دو تشکیل شده بود. با ارزیابی مدل بر روی مجموعهدادهٔ تست، ۸/۱٪ ردهبندی اشتباه و ۱۹/۴٪ بازپسزنی برای ۱٪ نرخ خطا در میان الگوهای تست باقیمانده به دست آمد که نشان میداد که این مدل نسبت به مدلهای ارائهشدهٔ پیشین از دقت بالاتری برخوردار است و استفاده از الگوریتم پسانتشار، روشی مناسب در فرایند تعلیم شبکههای عصبی عمیق است.[۱۸] لازم است ذکر شود که خود الگوریتم پسانتشار، از پیش و از ۱۹۷۰ نیز به عنوان حالت معکوس مشتق خودکار وجود داشت.[۱۹][۲۰]

تا سال ۱۹۹۱، چنین سامانههایی عموماً برای تشخیص ارقام دوبُعدی دستنویس ایزولهشده (به این معنا که ارقام به صورت تنها و بدون جزئیات و ویژگیهای اضافهٔ دیگری در پسزمینه - مثلاً متن و حروف اضافه - نوشتهشدهاند) به کار میرفتند؛ درحالی که بازشناسی اجسام سهبُعدی همچنان یک چالش بود. در سال ۱۹۹۲، پژوهشی از جان ونگ و همکاران با توضیح معایب و محدودیتهای شبکههای عصبی سهلایهای که برای این منظور به کار میرفتند، از مفهوم شبکهٔ سلسلهمراتبی (به انگلیسی: hierarchical network) استفاده کرده و مدلی موسوم به Cresceptron را ارائه دادند که قادر بود اجسام سهبعدی در محیطهای شلوغ را نیز تشخیص دهد.[۲۱][۲۲][۲۳] مفهوم تجمیع حداکثری (به انگلیسی: max pooling) نیز نخستینبار در همین پژوهش پیادهسازی شد.[نیازمند منبع] از آنجایی که این مدل میتوانست مستقیماً تصاویر طبیعی (سوژههای سهبعدی، با حضور عناصر دیگر در پسزمینه) را به عنوان ورودی دریافت کند، تبدیل به بنیانی برای یادگیری بصری همهمنظوره شد.

در سال ۱۹۹۴، آندره د کاروالیو به همراه مایک فیرهورست و دیوید بیسیت، معماریای مبتنی بر یک شبکهٔ عصبی بولی چندلایه را ارائه داد که تحت عنوان شبکهٔ عصبی بیوزن نیز شناخته میشد. این معماری از یک ماژول شبکهٔ عصبی سهلایهای خودساماندهندهٔ استخراج ویژگی (به انگلیسی: self-organising feature extraction یا SOFT) به همراه یک ماژول شبکهٔ عصبی چندلایهٔ ردهبندی (بهطور خاص یک شبکه با معماری GSN یا goal-seeking network) تشکیل شده بود که به صورت مستقل عملیات یادگیری را انجام میدادند. در ماژول استخراج ویژگی، تصویر ورودی به چند زیرمجموعه تقسیم شده و هر قسمت به یک بلاک از نورونها (که دارای سلسلهمراتب بوده و در چند لایه تقسیم شدهبودند) داده میشد و هر بلاک به صورت موازی با دیگر بلاکها و مستقل از آنها آموزش میدید.[۲۴][۲۵]

در سال ۱۹۹۵، یوزف زِپ هُخرایتر که پیشتر و در ۱۹۹۱ در پایاننامهٔ خود - تحت عنوان: بررسیهایی در شبکههای عصبی پویا (به آلمانی: Untersuchungen zu dynamischen neuronalen Netzen) - به بررسی مسئلهٔ گرادیان کاهشی پرداخته بود[۲۶] (که خود پیشتر و در ۱۸۴۷مطرح شده[۲۷] و در ۱۹۴۴ نیز برای مسائل بهینهسازی غیرخطی مورد مطالعه قرار گرفته بود[۲۸]) به همراه یورگن اشمیدهوبر، معماری الاستیام را ارائه داد[۲۹] و در مقالهٔ دیگری در سال ۱۹۹۷، آن را بهبود بخشید[۳۰] که زمینهٔ بزرگی را برای پیشرفت شبکههای عصبی بازگشتی فراهم ساخت[نیازمند منبع]. در همان سال ۱۹۹۵، برندن فرِی به همراه جفری هینتون و پیتر دایان نشان دادند که میتوان با استفاده از الگوریتم بیدار-خواب، شبکهای تشکیلشده از شش لایهٔ کاملاً همبند و با چندصد واحد پردازشی مخفی را آموزش داد.[۳۱]

علت محبوبیت یادگیری عمیق

[ویرایش]تا قبل از پیدایش یادگیری عمیق، روشهای یادگیری ماشین سنتی، بیشاز حد به بازنماییهایی (انتخاب ویژگیها) که از دادهها بهدست میآورند، وابسته بودند. این روشها، نیاز به یک متخصص در دامنه موضوع داشت تا استخراج ویژگیها را بهصورت دستی انجام دهد. حال آنکه، این استخراج ویژگیها به صورت دستی فرآیندی چالشانگیز و زمانبر است. پیدایش یادگیری عمیق توانست بهسرعت جایگزین این روشهای سنتی شود. چرا که میتوانست استخراج ویژگیها را بهصورت خودکار متناسب با هر مسئله بهدست آورد.[۳۲]

یادگیری عمیق هندسی

[ویرایش]در حالیکه مدلهای یادگیری عمیق در دهه گذشته، در برخورد با ورودیهایی به شکل تصاویر، گفتار یا ویدیو که اساس ساختار آنها اقلیدسی است، موفقیتآمیز عمل کرده، اخیراً، علاقه محققان در تلاش برای استفاده از یادگیری بر روی دادههای غیراقلیدسی افزایش یافتهاست. یادگیری عمیق هندسی، زمینه نوظهور تحقیقاتی است که سعی در تعمیم معماری یادگیری عمیق برای کار با دادههای غیراقلیدسی دارد، تا این شکاف را پر کند.[۳۲]

شبکه عصبی گراف

[ویرایش]شبکههای عصبی گراف، دستهای از روشهای یادگیری عمیق هستند که بهطور خاص، برای استنباط بر دادههای توصیفشده توسط گرافها طراحی شدهاند. ایجاد مدلهایی که مستقیماً بروی گرافها کار میکنند، مطلوبتر است. چراکه، میتوانیم اطلاعات بیشتری در مورد ساختار و خصوصیات آنها را بهدست آوریم.

شبکههای عصبی گراف، بهطور مستقیم برروی گرافها اعمال میشوند و روشی آسان برای انجام وظایفی همانند، پیشبینی سطح گره، یال و گراف ارائه میکنند. تا پیش از، توسعه شبکههای عصبی گراف، روشهای یادگیری عمیق توانایی اعمال برروی یالها در جهت استخراج دانش و پیشبینی را نداشتند. در عوض، تنها بر اساس ویژگیهای گره عمل میکردند.[۳۲]

کاربردها

[ویرایش]بینایی رایانه

[ویرایش]یکی از نخستین زمینههای بسیار موفق برای یادگیری عمیق که پتانسیل بالقوهٔ این روش در حل مسائل را نشان داد، در حوزهٔ بازشناسی تصویر رخ داد.

از سال ۲۰۱۰ و در پروژهای موسوم به ایمیجنت مسابقهای سالانه برگزار میشود که شرکتکنندگان با ارائهٔ الگوریتمهای کامپیوتری گوناگون، تلاش به بازشناسی تصاویر دیجیتالی در مقیاس کلان کرده و بر سر دستیابی به دقّتهای بالاتر با یکدیگر رقابت میکنند. حال در سال ۲۰۱۲، یک شبکهٔ عصبی همگشتی به نام الکسنت در این رقابت به کار رفت و با کسب نتایجی بسیار چشمگیر، توجههای گستردهای را به سوی روش یادگیری عمیق جلب کرد؛ به شکلی که به باور برخی، در این سال «انقلاب یادگیری عمیق» رخ داد. لازم است ذکر شود که دقت الکسنت در تشخیص تصاویر پایگاه دادهی ایمیجنت از دقت انسان نیز فراتر بود (هرچند البته حتی پیش از ارائهٔ الکسنت نیز الگوریتمهای دیگری به عملکرد فراانسانی دست پیدا کرده بودند).[۳۳][۳۴]

امروزه نیز شبکههای عصبی در بینایی رایانه دارای نقشی کلیدی بوده و برای اهداف گوناگونی چون بازشناسی تصویر، تشخیص چهره، رهگیری اجسام، حذف نویز، رنگیکردن تصاویر سیاه و سفید، ترمیم تصاویر آسیبدیده، ردهبندی تصاویر پزشکی و… به کار میرود.[۳۵]

بازشناسی خودکار گفتار

[ویرایش]از دیگر زمینههای موفق برای یادگیری عمیق، تشخیص و بازشناسی خودکار گفتار در مقیاس گسترده است که معمولاً توسط مدلهای مبتنی بر شبکه عصبی بازگشتی (به ویژه از نوع الاستیام) و شبکه عصبی همگشتی انجام میگیرد.[۳۶]

پردازش زبانهای طبیعی

[ویرایش]یادگیری عمیق اثر بزرگی در پیشرفت شاخهٔ پردازش زبانهای طبیعی ایجاد کرده و با ایجاد یک چهارچوب مدلسازی قدرتمند، به نتایج چشمگیری دست یافتهاست.[۳۷] به عنوان نمونه، مدل زبانی جیپیتی-۳ از اوپن ایآی با بهرهگیری روشهای یادگیری عمیق قادر به تولید متونی مشابه متون نوشتهشده توسط انسان است.[۳۸]

تشخیص الکترومیوگرافی

[ویرایش]سیگنالهای الکترومیوگرافی میتوانند به عنوان رابطی میان انسان و ماشین عمل کرده و با تحلیل آنها از مقصود کاربر جهت کنترل تجهیزات گوناگون بهره برد. به عنوان نمونه، افراد دچار نقص عضو میتوانند اعضایی مصنوعی را جایگزین عضو قطعشدهٔ خود کرده و آنها را به شیوهٔ مؤثری کنترل کنند. یا با همین روش میتوان اعضایی کمکی و تقویتکننده همچون اسکلت خارجی را کنترل کرد. برای تحلیل این سیگنالهای خام و ارائهٔ خروجی مناسب برای کنترل دستگاه، بهرهگیری از روش یادگیری عمیق میتواند بسیار کاربردی باشد.[۳۹]

سامانهٔ پیشنهادگر

[ویرایش]سامانههای پیشنهادگر از یادگیری عمیق جهت استخراج ویژگیهای معنادار برای یک مدل فاکتورهای پنهان به منظور پیشنهادهای محتوا-محور موسیقی و مجله بهره بردهاند.[۴۰][۴۱] یادگیری عمیق چنددیدگاهی (به انگلیسی: multi-view deep learning) جهت یادگیری ترجیحهای کاربر از چندین دامنه به کار میرود.[۴۲]

سرمایهگذاری

[ویرایش]در طرحهای سرمایهگذاری، از یادگیری عمیق برای افزایش میزان بازده استفاده میشود.[۴۳]

خودروی خودران

[ویرایش]گوگل و تسلا امروزه ثابت کردهاند که خودروهای بدون سرنشین یا خودران امکانپذیر هستند. اما به هرحال باید گفت این خودروها هنوز نیاز به یادگیری بیشتر و تمرین و آزمایشهای متفاوتی هستند و فعالیتها و متغیرهای بسیاری باید مورد بررسی قرار بگیرد.

تشخیص صدا

[ویرایش]تشخیص صدا جزئی جدانشدنی از فرایند زبان است. تحلیل صدای ورودی برای یک سامانه هوش مصنوعی بسیار سخت است؛ زیرا که عوامل متعددی در تشخیص درست صدا نقش دارند.

بهطور مثال وجود نویز در پیشزمینه، لهجهها، خلاقیتها و بازیهای زبانی افراد و همچنین ناتوانیهای خاص گفتاری و عوامل دیگر تشخیص دقیق واژههای به کار رفته در صدای به چیزی که رایانه بتواند آن را تحلیل کند، سخت میکند.

تشخیص الگو

[ویرایش]استفاده از شبکههای «یادگیری عمیق» میتواند در نرمافزارهای متعددی با تشخیص الگوی بهکار رفته توسط کاربر، کیفیت ارائهٔ خدمات را بالا ببرد.

هوش مصنوعیای که به خوبی با کاربر خود تطابق یافته باشد، میتواند اطلاعات غیر مرتبط را نادیده گرفته و برای کاربر اطلاعات مرتبط ارائه کند. تشخیص الگو همچنین میتواند تحلیل کلان داده را موثرتر سازد.

برنامهنویسی کامپیوتری

[ویرایش]هوش مصنوعی ضعیف، موفقیتهایی در حوزه تولید متن با معنا و پیشرفت در حوزه کدنویسی داشتهاست. بهطور مثال GPT-۳ از شرکت OpenAI یک نرمافزار اوپن سورس زبان تولیدکننده است که میتواند با کمترین دستورالعمل از سوی کاربر، کدنویسی کرده یا برنامههای ساده کامپیوتری ایجاد کند. در آینده احتمالاً شاهد حضور نرمافزارهای بیشتری که از این نوع فناوریها بهرهمندند خواهیم بود و کار با نرمافزارهای تخصصی رنگ و بوی دیگری به خود خواهد گرفت.

امنیت سایبری

[ویرایش]هوش مصنوعی نقش مهمتری در معیارهای امنیت سایبری سازمانها، افراد و دولتها به عهده خواهد گرفت که شامل نظارت، شناسایی تهدیدهای اطلاعاتی، اطلاع از نفوذ امنیتی، پاسخ به اتفاقات و تحلیل ریسک خواهد بود. هوش مصنوعی همچنان میتواند ابزارهای نظارتی قدرتمندی در اختیار دولتها قرار دهد تا بهطور راحتتری مخالفان خود را شناسایی کنند.

حوزه سرگرمی و تولید محتوا

[ویرایش]برنامههای رایانهای روزبهروز در تولید محتوا بهتر میشوند و هوش مصنوعی هماکنون نیز در شناسایی موارد تخلف قانون حق نشر، ساخت بازیهای ویدیویی و فیلمهای سینمایی نقش مهمی دارند و در آینده این نقش برجستهتر خواهد شد.

تصویربرداری پزشکی

[ویرایش]- تشخیص تصویر و تشخیص شی در فرآیندهایی مانند تشدید مغناطیسی (MR) و توموگرافی کامپیوتری (CT) برای کارهایی مانند تقسیمبندی تصویر، تشخیص بیماری و پیشبینی استفاده میشود.

- مدلهای یادگیری عمیق بهطور مؤثر دادههای تصویربرداری را با در نظر گرفتن فاکتورهایی مانند اندازه، حجم و شکل بافت تفسیر میکنند و میتوانند قسمتهای مهم در تصاویر را برجسته کنند.

- کاربردها شامل تشخیص رتینوپاتی دیابتی، تشخیص زودهنگام آلزایمر و تشخیص اولتراسوند ندولهای پستان است.

- انتظار میرود پیشرفت در یادگیری عمیق امکان بررسی جامع تصاویر پاتولوژی و رادیولوژی را در آینده فراهم کند.

الگوریتمهای یادگیری عمیق تجزیه و تحلیل دادههای پیچیده را ساده میکنند و دقت تشخیص ناهنجاری را افزایش میدهند. شبکههای عصبی کانولوشنال (CNN) بینشهایی را ارائه میکنند که به متخصصان پزشکی در شناسایی به موقع و دقیق مسائل بهداشتی کمک میکند. در یک مطالعه در سال ۲۰۱۸، CNNها بیش از ۱۰ درصد دقت بالاتری را در شناسایی ملانوم در مقایسه با متخصصان نشان دادند.

تجزیه و تحلیل دادههای بهداشت و درمان

[ویرایش]- مدلهای یادگیری عمیق بهطور مؤثر دادههای ساختاریافته و بدون ساختار را در پروندههای الکترونیک سلامت (EHR)، از جمله یادداشتهای بالینی، نتایج آزمایش، تشخیصها و داروها تجزیه و تحلیل میکنند.

- تلفنهای هوشمند و دستگاههای پوشیدنی اطلاعات ارزشمندی دربارهٔ شیوه زندگی ارائه میدهند و به تغییر دادهها برای نظارت بر عوامل خطر پزشکی با استفاده از برنامههای تلفن همراه کمک میکنند.

چت ربات سلامت روان

[ویرایش]- استفاده از برنامههای سلامت روان مبتنی بر هوش مصنوعی، از جمله رباتهای چت، در حال افزایش است و برخی از آنها از یادگیری عمیق برای تعاملات واقعی تر با بیمار استفاده میکنند.

- مطالعات نشان میدهد که عوامل مکالمه هوشمند میتوانند بهطور قابل توجهی علائم افسردگی و اضطراب را کاهش دهند و از سلامت روانی کارآمد و جذاب پشتیبانی کنند.

درمانهای پزشکی شخصی

[ویرایش]- راه حلهای یادگیری عمیق با تجزیه و تحلیل تاریخچه پزشکی، علائم و آزمایشها، مراقبت شخصی از بیمار را امکانپذیر میکند.

- پردازش زبان طبیعی (NLP) بینشهایی را از اطلاعات پزشکی متن آزاد استخراج میکند تا مناسبترین درمانها را تعیین کند.

حل معادلات دیفرانسیل با مشتقات جزیی

[ویرایش]- امکان استفاده از یادگیری عمیق به جای روشهای متداولی مانند روش تفاضل محدود یا روش اجزا محدود وجود دارد.[۴۴]

نساج شبکههای عصبی

[ویرایش]شبکههای عصبی عمیق (DNNs) مدلهای یادگیری هستند که دارای محاسبات خیلی زیادیاند. این مدلها کاربردهای روزافزونی در بخشهای مختلف دارند. از آنجا که FPGAها یک زیرساخت قابلبرنامهنویسی برای شتابدادن به محاسبات میدهند و همچنین امروزه در بیشتر دنیا به سادگی قابل دسترساند، FPGAها یک انتخاب خیلی خوب برای پیادهسازی مدلهای DNN هستند. اما استفاده از FPGAها به دلیل اینکه بهدست آوردن کارایی و مصرف انرژی کم آنها بهطور همزمان کار خیلی سختی است و همچنین DNNها به حافظه زیادی نیاز دارند (در FPGA معمولاً حافظه روی برد کم است)، پیادهسازی مدلها با FPGA بسیار دشوار است. نساج یا بافنده شبکههای عصبی (DNNWEAVER) یک چارچوب است که به صورت خودکار یک کد قابلسنتز برای یک زوج مرتب (DNN, FPGA) تولید میکند. مدل DNN را به صورتی که در Caffe معرفی میکنند به عنوان ورودی میدهند.

روند کلی کار این برنامه به این صورت است که ابتدا مدل ورودی را به یک زبان میانی تبدیل میکند که یک گراف از جریان داده کلی را نشان میدهد. در این مرحله با الگوریتمهای مختلف مدل داده شده را گروهبندی میکند تا با توجه به حافظه FPGA و دیگر منابع موجود روی FPGA به حداکثر استفاده مجدد از دادهها و بالاترین سطح کارایی برسد. بعد از آن نتیجه نهایی یک کد سنتزپذیر است که با بالاترین کارایی روی FPGA موردنظر تمامی نیازهای مدل ورودی را برآورده میسازد.

دید کلی از نساج شبکههای عصبی

[ویرایش]این کار کمک میکند تا چرخه طولانی لازم برای استفاده از FPGA در شبکههای عصبی عمیق کوتاهتر شود. هدف از این کار تولید یک چارچوب خودکار است که اولاً برنامهنویس را از جزئیات مربوط به طراحی و بهینهسازی سختافزار جدا میکند. دوماً خود چارچوب به منابع محدود موجود روی FPGA دست و پنجه نرم میکند؛ و در نهایت چارچوب پایدار برای FPGA فراهم میکند که کارایی بالایی را برای پیادهسازی مدلهای مختلف شبکههای عصبی عمیق روی FPGAهای گوناگون ارائه میکند. برای رسیدن به چنین هدفهایی DNNWEAVER طراحی شدهاست. در مرحله اول DNNWEAVER نیاز به یک مدل شبکه عصبی عمیق دارد که با استفاده از یک رابط سطح بالا مشخص شدهاست.

رابط مدلدادن

[ویرایش]ورودی برنامه DNNWEAVER یک توصیفگر سطح بالا از شبکههای عصبی عمیق است که در دانشگاه برکلی با نام قالب Caffe[۴۵] درست شدهاست.

Caffe یکی از پراستفادهترین چارچوبهای یادگیری عمیق است که توصیف شبکه را به عنوان ورودی میگیرد و به مدلی قابل اجرا روی CPU یا GPU تبدیل میکند.

DNNWEAVER به صورت خودکار مدل ورودی را به کد سنتزپذیر زبان وریلاگ تبدیل میکند. DNNWEAVER از چهار بخش نرمافزاری تشکیل شدهاست:

- ترجمهگر

- نقشهکش طرح

- نسّاج طرح

- مجتمعکننده

ترجمهگر

[ویرایش]ترجمهگر شبکه عمیق توصیفشده را به معماری مجموعه دستورها خاصی که مسیر داده را مشخص میکند تبدیل میکند. هر دستور در این مجموعه نشان دهنده یک گره در گراف مسیر داده شبکه است. توجه کنید که FPGA مستقیماً این دستورها را اجرا نمیکند. کامپایلر DNNWEAVER این دستورها را به سیگنالهای کنترلی FPGA مینگارد و یک تقویم اجرا را درست میکند. این روش یک واسط نرمافزار-سختافزار یکپارچه را فراهم میکند؛ بنابراین به کمک این معماری مجموعه دستورها انواع گوناگونی از پیادهسازی شتابدهندهها را که با محدودیتهای FPGA مقصد سازگار است، امکانپذیر میکند.

نقشهکش طرح

[ویرایش]نقشهکش طرح دستورها تولید شده در مرحله قبل را به عنوان ورودی میگیرد و با کمک الگوریتم بهینهسازی منابع الگو قالبهای سختافزاری را برای FPGA مقصد بهینه میکند. نقشهکش طرح محاسبات هر لایه را به گروههایی از عملگرها بخشبندی میکند که دادهها را به اشتراک میگذارند یا استفاده مجدد میکنند. به هرکدام این بخشها تکه میگوییم. هر تکه بعد از محاسبه در حافظه ریخته میشود و FPGA به سراغ محاسبه تکه بعدی میرود. شتابدهنده شبکههای عصبی مشکل اساسی با مقدار زیاد حافظه موردنیاز برخلاف حافظه کم FPGA دارد که DNNWEAVER این مشکل را با استفاده از الگوریتم بهینهسازی منابع الگو بهبود میدهد و به کمک آن یک تعادل بین عملگرهای موازی و استفاده مجدد از دادهها با توجه به محدودیتهای FPGA مقصد برقرار میکند.

نسّاج طرح

[ویرایش]نسّاجی طرح مرحله یکیمانده به آخر از DNNWEAVER است که ورودی آن مقدار منابع موردنیاز و تقویم اجرای تولید شده در مرحله قبل است و به کمک آن هسته شتابدهنده را تولید میکند. DNNWEAVER از تعدادی قالب بهینهسازی دستی استفاده میکند که با توجه به گرفتن منابع و سازماندهی سختافزار که در مرحله قبل تولید شده از آن قالبها استفاده میکند.

مجتمعکننده

[ویرایش]آخرین قسمت DNNWEAVER مجتمعکننده است. در این مرحله کدهای رابط حافظه به کدهای شتابدهنده اضافه میشود. از آنجایی که FPGAهای مختلف از رابطهای مختلفی برای ارتباط با DRAM خارجی استفاده میکنند، این بخش شامل کتابخانههایی از رابطهای DRAM است که در هر بار کد لازم را اضافه میکند.

دیگر کارهای مربوط

[ویرایش]در این حوزه کاری چندین سختافزار با اهداف مختلف ایجاد شدهاست. هر چند که DNNWEAVER یک شتابدهنده نیست، بلکه تولیدکننده کد یک شتابدهنده است.

Tabla[۴۶] یک شتابدهنده FPGA برای فاز آموزش الگوریتمهای یادگیری ماشین ارائه میکند در حالی که DNNWEAVER رو رابط شبکههای عصبی تمرکز دارد. Tabla از زبان ریاضیاتی مختص به خودش استفاده میکند در حالی که DNNWEAVER از زبان Caffe برای مشخص کردن مدل استفاده میکند.

کار انجام شده توسط چن و همکارانش[۴۷] روی طرحی تحلیلی بر اساس مدل خط بیشترین کار میکند تا با استفاده از آن سریعترین طرح را برای شبکه عصبی عمیق مربوط روی FPGA بیابند. اما این کار برخی لایهها مثل ائتلافی (Pooling) را دربر نمیگیرد.

جستارهای وابسته

[ویرایش]منابع

[ویرایش]- ↑ Bengio, Y. (2009). Learning Deep Architectures for AI (PDF). Now Publishers. Archived from the original (PDF) on 21 March 2014. Retrieved 17 February 2013.

- ↑ پایگاه اطلاعرسانی فناوری گرداب، Gerdab IR | (۲۳ بهمن ۱۴۰۰). «پرونده| الفبای هوش مصنوعی: آشنایی با هوش مصنوعی و حیطههای کاربرد آن (+ عکس)». fa. دریافتشده در ۲۰۲۳-۰۷-۰۱.[پیوند مرده]

- ↑ Song, Hyun Ah, and Soo-Young Lee. "Hierarchical Representation Using NMF." Neural Information Processing. Springer Berlin Heidelberg, 2013.

- ↑ Olshausen, Bruno A. "Emergence of simple-cell receptive field properties by learning a sparse code for natural images." Nature 381.6583 (1996): 607-609.

- ↑ Ronan Collobert (May 6, 2011). "Deep Learning for Efficient Discriminative Parsing". videolectures.net. Ca. 7:45.

- ↑ Gomes, Lee (20 October 2014). "Machine-Learning Maestro Michael Jordan on the Delusions of Big Data and Other Huge Engineering Efforts". IEEE Spectrum.

- ↑ Deng, L.; Yu, D. (2014). "Deep Learning: Methods and Applications" (PDF). Foundations and Trends in Signal Processing. 7 (3–4): 1–199. doi:10.1561/2000000039.

- ↑ DengLi; YuDong (2014-06-30). "Deep Learning". Foundations and Trends in Signal Processing (به انگلیسی). doi:10.1561/2000000039.

- ↑ Schulz, Hannes; Behnke, Sven (2012-11-01). "Deep Learning". KI - Künstliche Intelligenz (به انگلیسی). 26 (4): 357–363. doi:10.1007/s13218-012-0198-z. ISSN 1610-1987.

- ↑ «Paper by "Deep Learning Conspiracy" in Nature». people.idsia.ch. دریافتشده در ۲۰۲۰-۱۱-۰۴.

- ↑ Ivakhnenko, A. G. ; Lapa, V. G. (1967). Cybernetics and Forecasting Techniques. American Elsevier Publishing Co. ISBN 978-0-444-00020-0.

- ↑ Ivakhnenko, A. G. (1971-10). "Polynomial Theory of Complex Systems". IEEE Transactions on Systems, Man, and Cybernetics. SMC-1 (4): 364–378. doi:10.1109/TSMC.1971.4308320. ISSN 0018-9472.

{{cite journal}}: Check date values in:|date=(help) - ↑ Fukushima, Kunihiko (1980-04). "Neocognitron: A self-organizing neural network model for a mechanism of pattern recognition unaffected by shift in position". Biological Cybernetics. 36 (4): 193–202. doi:10.1007/bf00344251. ISSN 0340-1200.

{{cite journal}}: Check date values in:|date=(help) - ↑ Rina Dechter (1986). Learning while searching in constraint-satisfaction problems بایگانیشده در ۱۶ سپتامبر ۲۰۲۱ توسط Wayback Machine. (PDF) University of California, Computer Science Department, Cognitive Systems Laboratory.

- ↑ Schmidhuber, Juergen (2015-11-28). "Deep Learning". Scholarpedia (به انگلیسی). 10 (11): 32832. doi:10.4249/scholarpedia.32832. ISSN 1941-6016.

- ↑ Aizenberg, Igor N.; Aizenberg, Naum N.; Vandewalle, Joos (2000). "Multi-Valued and Universal Binary Neurons". doi:10.1007/978-1-4757-3115-6.

{{cite journal}}: Cite journal requires|journal=(help) - ↑ Gomez, Faustino J.; Schmidhuber, Jürgen (2005). "Co-evolving recurrent neurons learn deep memory POMDPs". Proceedings of the 2005 conference on Genetic and evolutionary computation - GECCO '05. New York, New York, USA: ACM Press. doi:10.1145/1068009.1068092. ISBN 1-59593-010-8.

- ↑ LeCun, Y.; Boser, B.; Denker, J. S.; Henderson, D.; Howard, R. E.; Hubbard, W.; Jackel, L. D. (1989). "Backpropagation Applied to Handwritten Zip Code Recognition" (PDF). Neural Computation. 1 (4): 541–551. doi:10.1162/neco.1989.1.4.541. ISSN 0899-7667.

- ↑ Linnainmaa, Seppo (1976-06). "Taylor expansion of the accumulated rounding error". BIT. 16 (2): 146–160. doi:10.1007/bf01931367. ISSN 0006-3835.

{{cite journal}}: Check date values in:|date=(help) - ↑ Griewank, Andreas. "Who invented the reverse mode of differentiation." Documenta Mathematica, Extra Volume ISMP (2012): 389-400. (PDF) https://www.math.uni-bielefeld.de/documenta/vol-ismp/52_griewank-andreas-b.pdf بایگانیشده در ۱۵ دسامبر ۲۰۲۳ توسط Wayback Machine

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Cresceptron: a self-organizing neural network which grows adaptively," Proc. International Joint Conference on Neural Networks, Baltimore, Maryland, vol I, pp. 576-581, June, 1992.

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation of 3-D objects from 2-D images," Proc. 4th International Conf. Computer Vision, Berlin, Germany, pp. 121-128, May, 1993.

- ↑ J. Weng, N. Ahuja and T. S. Huang, "Learning recognition and segmentation using the Cresceptron," International Journal of Computer Vision, vol. 25, no. 2, pp. 105-139, Nov. 1997.

- ↑ de Carvalho, A.; Fairhurst, M. C.; Bisset, D. L. (1994-08-01). "An integrated Boolean neural network for pattern classification". Pattern Recognition Letters (به انگلیسی). 15 (8): 807–813. doi:10.1016/0167-8655(94)90009-4. ISSN 0167-8655.

- ↑ de Carvalho, A.; Fairhurst, M.C.; Bisset, D.L. (1994). "A modular Boolean architecture for pattern recognition". Proceedings of 1994 IEEE International Conference on Neural Networks (ICNN'94). Orlando, FL, USA: IEEE. 7: 4349–4352. doi:10.1109/ICNN.1994.374967. ISBN 978-0-7803-1901-1.

- ↑ S. Hochreiter. , "Untersuchungen zu dynamischen neuronalen Netzen," Diploma thesis. Institut f. Informatik, Technische Univ. Munich. Advisor: J. Schmidhuber, 1991.

- ↑ Lemaréchal, C. (2012). "Cauchy and the Gradient Method بایگانیشده در ۲۹ دسامبر ۲۰۱۸ توسط Wayback Machine" (PDF). Doc Math Extra: 251–254.

- ↑ Curry, Haskell B. (1944). "The method of steepest descent for non-linear minimization problems". Quarterly of Applied Mathematics (به انگلیسی). 2 (3): 258–261. doi:10.1090/qam/10667. ISSN 0033-569X.

- ↑ S. Hochreiter, J. Schmidhuber. Long Short-Term Memory. Technical Report FKI-207-95, Technische Universitat München, München, August 1995. URL: http://citeseerx.ist.psu.edu/viewdoc/summary?doi=+10.1.1.51.3117.

- ↑ S. Hochreiter, J. Schmidhuber. (1997). "Long Short-Term Memory". Neural Computation. 9 (8): 1735–1780. doi:10.1162/neco.1997.9.8.1735. PMID 9377276. URL http://www.bioinf.jku.at/publications/+older/2604.pdf.

- ↑ Hinton, Geoffrey E. ; Dayan, Peter; Frey, Brendan J. ; Neal, Radford (1995-05-26). "The wake-sleep algorithm for unsupervised neural networks". Science. 268 (5214): 1158–1161. Bibcode:1995Sci...268.1158H. doi:10.1126/science.7761831. PMID 7761831.

- ↑ ۳۲٫۰ ۳۲٫۱ ۳۲٫۲ میلاد وزان، یادگیری عمیق: اصول، مفاهیم و رویکردها، میعاد اندیشه، 1399.

- ↑ Alom, Md Zahangir; Taha, Tarek M.; Yakopcic, Christopher; Westberg, Stefan; Sidike, Paheding; Nasrin, Mst Shamima; Van Esesn, Brian C.; Awwal, Abdul A. S.; Asari, Vijayan K. (2018-09-12). "The History Began from AlexNet: A Comprehensive Survey on Deep Learning Approaches". arXiv:1803.01164 [cs].

- ↑ «ImageNet Large Scale Visual Recognition Competition 2012 (ILSVRC2012)». www.image-net.org. دریافتشده در ۲۰۲۰-۱۱-۰۳.

- ↑ Voulodimos, Athanasios; Doulamis, Nikolaos; Doulamis, Anastasios; Protopapadakis, Eftychios (2018-02-01). "Deep Learning for Computer Vision: A Brief Review". Computational Intelligence and Neuroscience (به انگلیسی). Retrieved 2020-11-03.

- ↑ Kim, John; Saurous, Rif A. (2018-09-02). "Emotion Recognition from Human Speech Using Temporal Information and Deep Learning". Interspeech 2018. ISCA: ISCA. doi:10.21437/interspeech.2018-1132.

- ↑ Deng, Li; Liu, Yang, eds. (2018). "Deep Learning in Natural Language Processing". doi:10.1007/978-981-10-5209-5.

{{cite journal}}: Cite journal requires|journal=(help) - ↑ "OpenAI API". OpenAI (به انگلیسی). 2020-06-11. Retrieved 2020-11-03.

- ↑ Jafarzadeh, M.; Hussey, D. C.; Tadesse, Y. (2019-09). "Deep learning approach to control of prosthetic hands with electromyography signals". 2019 IEEE International Symposium on Measurement and Control in Robotics (ISMCR): A1–4–1-A1-4-11. doi:10.1109/ISMCR47492.2019.8955725.

{{cite journal}}: Check date values in:|date=(help) - ↑ van den Oord, Aäron; Dieleman, Sander; Schrauwen, Benjamin (2013-03-14). "Learning a piecewise linear transform coding scheme for images". International Conference on Graphic and Image Processing (ICGIP 2012). SPIE. doi:10.1117/12.2011134.

- ↑ Feng, Xiaoyue; Zhang, Hao; Ren, Yijie; Shang, Penghui; Zhu, Yi; Liang, Yanchun; Guan, Renchu; Xu, Dong (2019). "The Deep Learning–Based Recommender System "Pubmender" for Choosing a Biomedical Publication Venue: Development and Validation Study". Journal of Medical Internet Research (به انگلیسی). 21 (5): e12957. doi:10.2196/12957. PMC 6555124. PMID 31127715.

{{cite journal}}: نگهداری یادکرد:فرمت پارامتر PMC (link) - ↑ Elkahky, Ali Mamdouh; Song, Yang; He, Xiaodong (2015). "A Multi-View Deep Learning Approach for Cross Domain User Modeling in Recommendation Systems". Proceedings of the 24th International Conference on World Wide Web - WWW '15. New York, New York, USA: ACM Press. doi:10.1145/2736277.2741667. ISBN 978-1-4503-3469-3.

- ↑ «Improving Stock Return Forecasting by Deep Learning Algorithm» (PDF). Advances in mathematical finance & applications. ۴ (۳): ۱۳. ۳ فوریه ۲۰۱۹. doi:10.22034/amfa.2019.584494.1173. دریافتشده در ۳۰ مه ۲۰۱۹.

- ↑ «DL-PDE: Deep-learning based data-driven discovery of partial differential equations from discrete and noisy data».

- ↑ Yangqing Jia, Evan Shelhamer, Jeff Donahue, Sergey Karayev, Jonathan Long, Ross Girshick, Sergio Guadarrama, and Trevor Darrell. Caffe: Convolutional architecture for fast feature embedding. arXiv preprint

- ↑ Divya Mahajan, Jongse Park, Emmanuel Amaro, Hardik Sharma, Amir Yazdanbakhsh, Joon Kyung Kim, and Hadi Esmaeilzadeh. Tabla: A unified template-based framework for accelerating statistical machine

- ↑ Chen Zhang, Peng Li, Guangyu Sun, Yijin Guan, Bingjun Xiao, and Jason Cong. Optimizing fpga-based accelerator design for deep convolutional neural networks. In FPGA, 2015.

- DNNWEAVER Article 2016 بایگانیشده در ۳۱ مارس ۲۰۱۷ توسط Wayback Machine

- Page of DNNWEAVER