قضیه بیز

| بخشی از مجموعه مباحث درباره آمار |

| نظریهٔ احتمالات |

|---|

|

| اصول احتمال |

| فضای احتمالی * فضای نمونه * پیشامد ابتدایی * پیشامد * اندازه احتمالاتی |

| پیشامد مکمل * توزیع احتمال توأم * توزیع حاشیهای * احتمال شرطی |

| متغیرهای تصادفی مستقل * مستقل شرطی * قانون احتمال کامل * قانون اعداد بزرگ * قضیه بیز * نابرابری بول |

| نمودار ون * نمودار درختی |

قضیه بیز (به انگلیسی: Bayes' theorem) روشی برای دستهبندی پدیدهها، بر پایه احتمال وقوع یا عدم وقوع یک پدیده است و در نظریهٔ احتمالات با اهمیت و پرکاربرد است. اگر برای فضای نمونهای مفروضی بتوانیم چنان افرازی انتخاب کنیم که با دانستن اینکه کدامیک از پیشامدهای افراز شده رخ دادهاست، بخش مهمی از عدم قطعیت تقلیل مییابد.

این قضیه از آن جهت مفید است که میتوان از طریق آن، احتمال یک پیشامد را با مشروط کردن نسبت به وقوع یا عدم وقوع یک پیشامد دیگر محاسبه کرد. در بسیاری از حالتها، محاسبهٔ احتمال یک پیشامد به صورت مستقیم کاری دشوار است. با استفاده از این قضیه و مشروط کردن پیشامد مورد نظر نسبت به پیشامد دیگر، میتوان احتمال مورد نظر را محاسبه کرد.

این رابطه به خاطر بزرگداشت توماس بیز فیلسوف انگلیسی به نام فرمول بیز معروف است.

معادلهٔ اصلی

[ویرایش]فرض میکنیم یک افراز برای فضای نمونهای تشکیل دهند. طوریکه به ازای هر ، داشته باشیم و فرض کنید پیشامدی با فرض باشد، در اینصورت به ازای ، داریم:

برهان

[ویرایش]

طبق تعریف احتمال شرطی داریم . صورت کسر قضیه طبق دستور حاصلضرب در احتمال شرطی، برابر با و مخرج کسر بنابر قضیه قانون احتمال کل، برابر است.

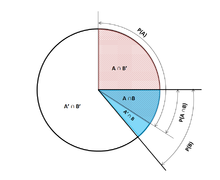

اگر A و B دو پیشامد مفروض باشند، میتوان پیشامد A را به صورت زیر در نظر بگیریم:

زیرا نقطهای که در باشد باید یا در هر دوی و باشد یا این که در باشد و در وجود نداشته باشد. از طرفی میدانیم و ناسازگار هستند، پس میتوان نوشت:

این رابطه بیان میدارد که احتمال به وقوع پیوستن پیشامد یک میانگین وزنی از احتمال شرطی و احتمال شرطی میباشد. وزن داده شده به هر احتمال شرطی به اندازهٔ احتمالی است که نسبت به آن مشروط شدهاست. رابطه بالا را میتوان به صورت زیر تعمیم داد. فرض کنید پیشامدهای ، ، … و پیشامدهای دو به دو ناسازگار باشند از طرفی رابطهٔ زیر نیز بین این پیشامدها برقرار است:

از این عبارت این گونه میتوان استنباط کرد که حتماً یکی از پیشامدهای ، ، … و باید اتفاق بیفتد. از طرفی میدانیم که پیشامدهای برای ، دو به دو ناسازگار هستند و مینویسیم:

از اینجا میتوان نوشت:

این رابطه بیان میدارد که چگونه میتوان را با مشروط کردن به یکی از پیشامدهای داده شدهٔ ، ، … و محاسبه نمود. بهطور کلی این رابطه باین میدارد که برابر است با میانگین وزنی به نحوی که هر وزن هر جمله برابر با احتمالی است که به آن مشروط گردیدهاست حال فرض کنید که پیشامد A اتفاق افتاده و میخواهیم احتمال این که یکی از پیشامدهای اتفاق افتاده باشد را حساب کنیم:

یادگیری ماشینی به کمک نظریه بیز

[ویرایش]برای نگرش بیزی به یادگیری ماشین (و یا هر فرایند دیگر) میباید نخست:

- دانش موجود دربارهٔ موضوع را به صورت احتمالاتی فرموله کنیم:برای اینکار باید مقادیر کیفی دانش را به صورت توزیع احتمال، فرضیات استقلال و غیره مدل کرد. این مدل دارای پارامترهای ناشناختهای خواهد بود که برای هر یک از مقادیر ناشناخته، توزیع احتمال اولیهای در نظر گرفته میشود که بازگوکننده باور ما به محتمل بودن هر یک از این مقادیر بدون دیدن دادهاست.

- با جمعآوری داده و مشاهدهٔ آن، مقدار توزیع احتمال ثانویه را محاسبه میکنیم

- با استفاده از این احتمال ثانویه:

- به یک نتیجهگیری در مورد عدم قطعیت میرسیم

- با میانگینگیری روی مقادیر احتمال ثانویه پیشبینی انجام میدهیم

- برای کاهش خطای ثانویه مورد انتظار تصمیمگیری میکنیم

تئوری بیز در یادگیری ماشین

[ویرایش]در یادگیری ماشین معمولاً در فضای فرضیه بدنبال بهترین فرضیهای هستیم که در مورد دادههای آموزشی صدق کند. یک راه تعیین بهترین فرضیه، این است که بدنبال محتملترین فرضیهای باشیم که با داشتن دادههای آموزشی و احتمال قبلی در مورد فرضیههای مختلف میتوان انتظار داشت تئوری بیز چنین راه حلی را ارائه میدهد. این روش راه حل مستقیمی است که نیازی به جستجو ندارد.

سنگ بنای یادگیری بیزی را تئوری بیز تشکیل میدهد. این تئوری امکان محاسبه احتمال ثانویه را بر مبنای احتمالات اولیه میدهد:

همانطور که مشاهده میشود با افزایش مقدار کاهش مییابد؛ زیرا هر چه احتمال مشاهده مستقل از بیشتر باشد به این معنا خواهد بود که شواهد کمتری در حمایت از hدربردارد.

تعریف مفاهیم اولیه

[ویرایش]فرض کنید که فضای فرضیه و مجموعه مثالهای آموزش موجود باشند. مقادیر احتمال زیر را تعریف میکنیم:

- : احتمال پیشین (prior probablity) که فرضیه قبل از مشاهده داده آموزشی داشتهاست. اگر چنین احتمالی موجود نباشد میتوان به تمامی فرضیهها احتمال یکسانی نسبت داد.

- : احتمال مشاهده داده آموزشی .

- : درست نمایی (likelihood) یا احتمال مشاهده داده آموزشی به فرض آنکه فرضیه صادق باشد.

- : احتمال پسین (posterior probablity) یا احتمال فرضیه به شرط مشاهده داده آموزشی .

توجه شود که احتمال پیشین مستقل از داده آموزشی است، ولی احتمال پسین تأثیر داده آموزشی را منعکس میکند.

روشهای یادگیری بیزی ماشینی

[ویرایش]روشهای بیزی فرضیههایی ارائه میدهند که قادر به پیشبینی احتمالی هستند (مثل بیمار به احتمال ۹۳٪ بهبود مییابد) مثالهای جدید را میتوان با ترکیب وزنی چندین فرضیه دستهبندی نمود. حتی در مواردی که روشهای بیزی قابل محاسبه نباشند، میتوان از آنها به عنوان معیاری برای ارزیابی روشهای دیگر استفاده کرد تعدادی از روشهای یادگیری ماشینی بیزی شامل موارد زیر است:

مثال

[ویرایش]در یک مسئله تشخیص بیماری با دو فرضیه روبرو هستیم:

- بیمار دارای سرطان است.

- بیمار سالم است.

دادهای آزمایشگاهی نشان میدهد که ۰٫۰۰۸ جمعیت دارای این بیماری هستند و بعلت نادقیق بودن تستهای آزمایشگاهی نتایج آن به صورت زیر است:

- در ۹۸٪ مواقعی که شخص واقعاً بیمار است نتیجه صحیح مثبت حاصل میشود.

- در ۹۷٪ مواقعی که بیمار سالم است نتیجه صحیح منفی حاصل میشود.

احتمال مثبت بودن جواب آزمایش:

حال اگر بیمار جدیدی مشاهده شود که جواب آزمایشگاه مثبت باشد، آیا باید بیمار را مبتلا به سرطان بدانیم؟ احتمال ابتلای بیمار به سرطان عبارت است از:

احتمال نداشتن سرطان عبارت است از:

لذا فرضیه MAP عبارت خواهد بود از:

- hmap=~cancer

جستارهای وابسته

[ویرایش]منابع

[ویرایش]- دگروت-اسکرویش (۱۳۸۵)، احتمال و آمار جلد اول، ترجمهٔ دکتر عینالله پاشا، ص. ۹۸، شابک ۹۷۸-۹۶۴-۳۹۵-۸۷۱-۸

sheldon ross sixth edition، A first course of probability